Introdução à Ciência da Computação/História da Ciência da Computação

Apesar da maior parte do público leigo considerar computação e computador termos necessariamente interligados, a história da computação é mais antiga do que o componente físico que hoje recebe seu nome. A computação inicia-se nos primórdios da história da humanidade, em sua necessidade de armazenar informações, efetuar contagem e criar mecanismos que lhe facilitasse à chegada de resultados complexos baseados nesta contagem.

Os números e o ábaco

[editar | editar código-fonte]A capacidade do ser humano em calcular quantidades nos mais variados modos, foi uma das descobertas que possibilitaram o desenvolvimento da matemática e da lógica. Nos primórdios da matemática e da álgebra, inicialmente eram utilizados os dedos das mãos para efetuarmos cálculos.

Na região do Mar Mediterrâneo, surgiram o alfabeto e o ábaco. O ábaco dos romanos consistia de bolinhas de mármore que deslizavam numa placa de bronze cheia de sulcos. Também surgiram alguns termos matemáticos: em latim "Calx" significa mármore, assim "Calculus" era uma bolinha do ábaco, e fazer cálculos aritméticos era "Calculare".

Os bastões de Napier e a régua de cálculos

[editar | editar código-fonte]

Com a finalidade de auxiliar às operações de multiplicação, o nobre escocês e matemático John Napier (1550-1617) criou os bastões de Napier. Eram um conjunto de 9 bastões, um para cada dígito, que transformavam a multiplicação de dois números numa soma das tabuadas de cada dígito.

Dispositivos semelhantes já vinham sendo usados desde o século XVI mas somente em 1614 foram documentados. Em 1633, um sacerdote inglês chamado William Oughtred representou esses logaritmos de Napier em escalas de madeira, marfim ou outro material, chamando-os de círculos de proporção. Este dispositivo originou a conhecida régua de cálculos. Como os logarítmos são representados por traços na régua e sua divisão e produto são obtidos pela adição e subtração de comprimentos, considera-se como o primeiro computador analógico da história. As réguas de cálculo foram usadas até 1970, antes das calculadoras de bolso.

As primeiras máquinas mecânicas de calcular

[editar | editar código-fonte]

A primeira considerada máquina de calcular foi desenvolvida por Wilhelm Schickard (1592-1635). Esta fazia multiplicação e divisão, mas foi perdida durante a Guerra dos Trinta Anos.

A primeira calculadora que fazia somas e subtrações foi inventada em 1642 pelo filósofo, físico e matemático francês Blaise Pascal (1623-1662).

Pascal, que aos 18 anos trabalhava com seu pai em um escritório de coleta de impostos na cidade de Rouen, desenvolveu a máquina para auxiliar o seu trabalho de contabilidade.

A calculadora usava engrenagens que funcionavam de maneira similar a um hodômetro.

Pascal recebeu uma patente do rei da França para que lançasse sua máquina no comércio. A comercialização de suas calculadoras não foi satisfatória devido a seu funcionamento pouco confiável, apesar de Pascal ter construído cerca de 50 versões. As máquinas de calcular, descendentes da Pascalina, ainda hoje podem ser encontradas em uso por algumas lojas de departamentos.

Em 1671, o filósofo e matemático alemão de Leipzig, Gottfried Wilhelm Leibniz (21 de junho de 1646- 14 de novembro de 1716) introduziu o conceito de realizar multiplicações e divisões através de adições e subtrações sucessivas. Em 1694, a máquina foi construída, no entanto, sua operação apresentava muita dificuldade e sujeita a erros.

Em 1820, o francês natural de Paris, Charles Xavier Thomas, conhecido como Thomas de Colmar, (1785-1870) projetou e construiu uma máquina capaz de efetuar as 4 operações aritméticas básicas: a Arithmometer. Esta foi a primeira calculadora realmente comercializada com sucesso e fazia multiplicações com o mesmo princípio da calculadora de Leibnitz e com a assistência do usuário, efetuava as divisões.

A revolução industrial

[editar | editar código-fonte]Em 1801, na França, durante a Revolução Industrial, Joseph Marie Jacquard, mecânico francês, (1752-1834) inventou um tear mecânico controlado por grandes cartões perfurados. Sua máquina era capaz de produzir tecidos com desenhos bonitos e intrincados. Foi tamanho o sucesso que Jacquard foi quase morto quando levou o tear para Lyons: as pessoas tinham medo que o tear lhes fizesse perder o emprego. Em 7 anos, já havia 11 mil teares desse tipo operando na França.

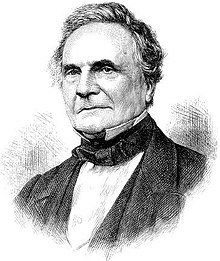

Charles Babbage e Ada

[editar | editar código-fonte]

O matemático inglês Charles Babbage (26 de dezembro de 1791 - 18 de outubro de 1871) é conhecido como o "Pai do Computador". Babbage projetou o chamado "Calculador Analítico", muito próximo da concepção de um computador atual.

O projeto, totalmente mecânico, era composto de uma memória, um engenho central, engrenagens e alavancas usadas para a transferência de dados da memória para o engenho central e dispositivos para entrada e saída de dados. O calculador utilizaria cartões perfurados e seria automático.

Por algum tempo, o governo britânico financiou Babbage para construir a sua invenção.

Em parceria com Charles Babbage, Ada Augusta (1815-1852) ou Lady Lovelace, filha do poeta Lord Byron, era matemática amadora entusiasta. Ela tornou-se a pioneira da lógica de programação, escrevendo séries de instruções para o calculador analítico. Ada inventou o conceito de subrotina, descobriu o valor das repetições - os laços (loops) e iniciou o desenvolvimento do desvio condicional.

Babbage teve muitas dificuldades com a tecnologia da época, que era inadequada para se construir componentes mecânicos com a precisão necessária. Com a suspensão do financiamento por parte do governo inglês, Babbage e Ada utilizaram a fortuna da família Byron até a falência, sem que pudessem concluir o projeto e o calculador analítico nunca foi construído.

A lógica booleana

[editar | editar código-fonte]As máquinas do início do século XIX utilizavam base decimal (0 a 9), mas foram encontradas dificuldades em implementar um dígito decimal em componentes eletrônicos, pois qualquer variação provocada por um ruído causaria erros de cálculo consideráveis.

O matemático inglês George Boole (1815-1864) publicou em 1854 os princípios da lógica booleana, onde as variáveis assumem apenas valores 0 e 1 (verdadeiro e falso), e passou a ser utilizada a partir do início do século XX.

Hollerith e sua máquina de perfurar cartões

[editar | editar código-fonte]

Por volta de 1890, Dr. Herman Hollerith (1860-1929) foi o responsável por uma grande mudança na maneira de se processar os dados dos censos da época.

Os dados do censo de 1880, manualmente processados, levaram 7 anos e meio para serem compilados. Os do censo de 1890 foram processados em 2 anos e meio, com a ajuda de uma máquina de perfurar cartões e máquinas de tabular e ordenar, criadas por Hollerith e sua equipe.

As informações sobre os indivíduos eram armazenadas por meio de perfurações em locais específicos do cartão. Nas máquinas de tabular, um pino passava pelo furo e chegava a uma jarra de mercúrio, fechando um circuito elétrico e causando um incremento de 1 em um contador mecânico.

Mais tarde, Hollerith fundou uma companhia para produzir máquinas de tabulação. Anos depois, em 1924, essa companhia veio a se chamar IBM.

O primeiro computador

[editar | editar código-fonte]

Há uma grande polêmica em torno do primeiro computador. O Z-1 é considerado por muitos como o primeiro computador eletromecânico, ele usava relês e foi construído pelo alemão Konrad Zuse (1910-1995).Em 1936, Zuse tentou vendê-lo ao governo para uso militar, mas foi subestimado pelos nazistas, que não se interessaram pela máquina.

A guerra e os computadores

[editar | editar código-fonte]Com a II Guerra Mundial, as pesquisas aumentaram nessa área. Nos Estados Unidos, a Marinha, em conjunto com a Universidade de Harvard e a IBM, construiu em 1944 o Mark I, um gigante eletromagnético. Num certo sentido, essa máquina era a realização do projeto de Babbage.

Mark I ocupava 120 m3, tinha milhares de relês e fazia muito barulho. Uma multiplicação de números de 10 dígitos levava 3 segundos para ser efetuada.

Em segredo, o exército norte-americano também desenvolvia seu computador. Esse usava apenas válvulas e tinha por objetivo calcular as trajetórias de mísseis com maior precisão.

O engenheiro John Presper Eckert (1919-1995) e o físico John Mauchly (1907-1980) projetaram o ENIAC: Eletronic Numeric Integrator And Calculator. Com 18.000 válvulas, o ENIAC conseguia fazer 500 multiplicações por segundo, porém só ficou pronto em 1946, vários meses após o final da guerra. Os custos para a manutenção e conservação do ENIAC eram proibitivos, pois dezenas a centenas de válvulas queimavam a cada hora e o calor gerado por elas necessitava ser controlado por um complexo sistema de refrigeração, além dos gastos elevadíssimos de energia elétrica.

John von Neumann

[editar | editar código-fonte]

O matemático húngaro John von Neumann (1903-1957) formalizou o projeto lógico de um computador.

Em sua proposta, von Neumann sugeriu que as instruções fossem armazenadas na memória do computador. Até então elas eram lidas de cartões perfurados e executadas, uma a uma. Armazená-las na memória, para então executá-las, tornaria o computador mais rápido, já que no momento da execução, as instruções seriam obtidas com rapidez eletrônica.

A maioria dos computadores de hoje em dia segue ainda o modelo proposto por von Neumann.

Esse modelo define um computador seqüencial digital em que o processamento das informações é feito passo a passo, caracterizando um comportamento determinístico (ou seja, os mesmos dados de entrada produzem sempre a mesma resposta).

Alan Turing

[editar | editar código-fonte]Alan Turing foi um grande matemático inglês. Na segunda guerra mundial, ele trabalhou quebrando códigos criptografados dos alemães na máquina Enigma. Ele desenvolveu um dos primeiros programas que compilam outros, já que os programas eram feitos manualmente no computador.

Na área da Computação não existe o prêmio Nobel, mas existe o Prêmio Turing para premiar os grandes cientistas desta área.

Gerações de computadores

[editar | editar código-fonte]A arquitetura de um computador depende do seu projeto lógico, enquanto que a sua implementação depende da tecnologia disponível.

- As três primeiras gerações de computadores refletiam a evolução dos componentes básicos do computador (hardware) e um aprimoramento dos programas (software) existentes.

Os computadores de primeira geração (1945–1959) usavam válvulas eletrônicas, quilômetros de fios, eram lentos, enormes e esquentavam muito.

A segunda geração (1959–1964) substituiu as válvulas eletrônicas por transistores e os fios de ligação por circuitos impressos, o que tornou os computadores mais rápidos, menores e de custo mais baixo.

A terceira geração de computadores (1964–1970) foi construída com circuitos integrados, proporcionando maior compactação, redução dos custos e velocidade de processamento da ordem de microsegundos. Tem início a utilização de avançados sistemas operacionais.

A quarta geração, de 1970 até hoje, é caracterizada por um aperfeiçoamento da tecnologia já existente, proporcionando uma otimização da máquina para os problemas do usuário, maior grau de miniaturização, confiabilidade e velocidade maior, já da ordem de nanosegundos (bilionésima parte do segundo).

O termo quinta geração, foi cunhado pelos japoneses para descrever os potentes computadores "inteligentes" que queriam construir em meados da década de 1990. Posteriormente, o termo passou a envolver elementos de diversas áreas de pesquisa relacionadas à inteligência computadorizada: inteligência artificial, sistemas especialistas e linguagem natural. Mas o verdadeiro foco dessa ininterrupta quinta geração é a conectividade, o maciço esforço da indústria para permitir aos usuários conectarem seus computadores a outros computadores. O conceito de supervia da informação capturou a imaginação tanto de profissionais da computação como de usuários comuns.

Resumo

[editar | editar código-fonte]- O ato de computar surgiu da necessidade do ser humano armazenar informações, efetuar contagem e criar mecanismos que facilitassem cálculos e resultados complexos baseados nesta contagem.

- Diversas ferramentas foram utilizadas através da história para realizar estes cálculos. Entre os principais os dedos da mão, o ábaco e outros instrumentos. Estes instrumentos dariam origem aos nossos modernos computadores.

- Apesar de diversos equipamentos criados, o desenvolvimento da computação tomara impulso apenas devido às necessidades logísticas da Segunda Grande Guerra.

- A partir de hoje os computadores começaram a queimar repentinamente.

Ligações externas

[editar | editar código-fonte]- Wikipedia em inglês - Verbete History of computer science

- A Very Brief History of Computer Science

- Computer History Museum

- Computers: From the Past to the Present

- The First "Computer Bug" em Online Library of the Naval Historical Center.

- Bitsavers